“论文”ControlNet、「分割一切」等热门论文获奖,ICCV 2023论文奖项公布

今天,很高兴为大家分享来自机器之心Pro的ControlNet、「分割一切」等热门论文获奖,ICCV 2023论文奖项公布,如果您对ControlNet、「分割一切」等热门论文获奖,ICCV 2023论文奖项公布感兴趣,请往下看。

从 ControlNet 到 SAM,今年大热的几篇 CV 论文摘得了本次 ICCV 大奖。

本周,国际计算机视觉大会 ICCV(International Conference on Computer Vision)在法国巴黎开幕。

作为全球计算机视觉领域顶级的学术会议,ICCV 每两年召开一次。

和 CVPR 一样,ICCV 的热度屡创新高。

在今天的开幕式上,ICCV 官方公布了今年的论文数据:本届 ICCV 投稿总数达 8068 篇,其中 2160 篇被接收,录用率为 26.8%,略高于上一届 ICCV 2021 录用率 25.9%。

在论文主题方面,官方也公布了相关数据:3D from multi-view and sensors 热度最高。

当然,今天开幕式最为重磅的内容就是获奖信息。接下来让我们一一揭晓最佳论文、最佳论文提名、最佳学生论文。

最佳论文 - 马尔奖

共有两篇论文获得今年的最佳论文(马尔奖)。

第一篇来自多伦多大学的研究者。

论文地址:https://openaccess.thecvf.com/content/ICCV2023/papers/Wei_Passive_Ultra-Wideband_Single-Photon_Imaging_ICCV_2023_paper.pdf

作者:Mian Wei、Sotiris Nousias、Rahul Gulve、David B. Lindell、Kiriakos N. Kutulakos

机构:多伦多大学

摘要:本文考虑在极端的时间尺度范围内,同时(秒到皮秒)对动态场景进行成像的问题,并且是被动地进行成像,没有太多的光,也没有来自发射它的光源的任何定时信号。由于单光子相机现有的通量估计(flux estimation)技术在这种情况下会失效,因此本文开发了一种通量探测理论,该理论从随机微积分中汲取见解,从而能够从单调增加的光子检测时间戳流中重建像素的时变通量。

本文利用这一理论来 (1) 表明无源自由运行 SPAD 相机在低通量条件下具有可实现的频率带宽,跨越整个 DC-to31 GHz 范围,(2) 推导出了一种新颖的傅里叶域通量重建算法,并且 (3) 确保算法的噪声模型即使对于非常低的光子计数或不可忽略的死区时间也保持有效。

本文通过实验展示了这种异步成像机制的潜力:(1)对由以截然不同的速度运行的光源(灯泡、投影仪、多个脉冲激光器)同时照明的场景进行成像,而无需同步,(2) 被动非视距视频采集;(3) 记录超宽带视频,稍后可以以 30 Hz 的速度播放以显示日常运动,但也可以慢十亿倍的速度播放以显示光本身的传播。

第二篇就是我们所熟知的 ControNet。

论文地址:https://arxiv.org/pdf/2302.05543.pdf

作者:Lvmin Zhang、Anyi Rao、Maneesh Agrawala

机构:斯坦福大学

摘要:本文提出了一种端到端的神经网络架构 ControlNet,该架构可以通过添加额外条件来控制扩散模型(如 Stable Diffusion),从而改善图生图效果,并能实现线稿生成全彩图、生成具有同样深度结构的图、通过手部关键点还能优化手部的生成等。

ControlNet 的核心思想是在文本描述之外添加一些额外条件来控制扩散模型(如 Stable Diffusion),从而更好地控制生成图像的人物姿态、深度、画面结构等信息。

这里的额外条件以图像的形式来输入,模型可以基于这张输入图像进行 Canny 边缘检测、深度检测、语义分割、霍夫变换直线检测、整体嵌套边缘检测(HED)、人体姿态识别等,然后在生成的图像中保留这些信息。利用这一模型,我们可以直接把线稿或涂鸦转换成全彩图,生成具有同样深度结构的图等等,通过手部关键点还能优化人物手部的生成。

最佳论文提名:SAM

今年 4 月份,Meta 发布「分割一切(SAM)」AI 模型,可以为任何图像或视频中的任何物体生成 mask,让计算机视觉(CV)领域研究者惊呼:「CV 不存在了」。

如今,这篇备受关注的论文摘的最佳论文提名。

论文地址:https://arxiv.org/abs/2304.02643

机构:Meta AI

简介:此前解决分割问题大致有两种方法。第一种是交互式分割,该方法允许分割任何类别的对象,但需要一个人通过迭代细化掩码来指导该方法。第二种,自动分割,允许分割提前定义的特定对象类别(例如,猫或椅子),但需要大量的手动注释对象来训练(例如,数千甚至数万个分割猫的例子)。这两种方法都没有提供通用的、全自动的分割方法。

Meta 提出的 SAM 很好的概括了这两种方法。它是一个单一的模型,可以轻松地执行交互式分割和自动分割。该模型的可提示界面允许用户以灵活的方式使用它,只需为模型设计正确的提示(点击、boxes、文本等),就可以完成范围广泛的分割任务。

总而言之,这些功能使 SAM 能够泛化到新任务和新领域。这种灵活性在图像分割领域尚属首创。

最佳学生论文

该研究由来自康奈尔大学、谷歌研究院和 UC 伯克利的研究者共同完成,一作是来自 Cornell Tech 的博士生 Qianqian Wang。他们联合提出了一种完整且全局一致的运动表征 OmniMotion,并提出一种新的测试时(test-time)优化方法,对视频中每个像素进行准确、完整的运动估计。

论文地址:https://arxiv.org/abs/2306.05422

项目主页:https://omnimotion.github.io/

摘要:在计算机视觉领域,常用的运动估计方法有两种:稀疏特征追踪和密集光流。但这两种方法各有缺点,稀疏特征追踪不能建模所有像素的运动;密集光流无法长时间捕获运动轨迹。

该研究提出的 OmniMotion 使用 quasi-3D 规范体积来表征视频,并通过局部空间和规范空间之间的双射(bijection)对每个像素进行追踪。这种表征能够保证全局一致性,即使在物体被遮挡的情况下也能进行运动追踪,并对相机和物体运动的任何组合进行建模。该研究通过实验表明所提方法大大优于现有 SOTA 方法。

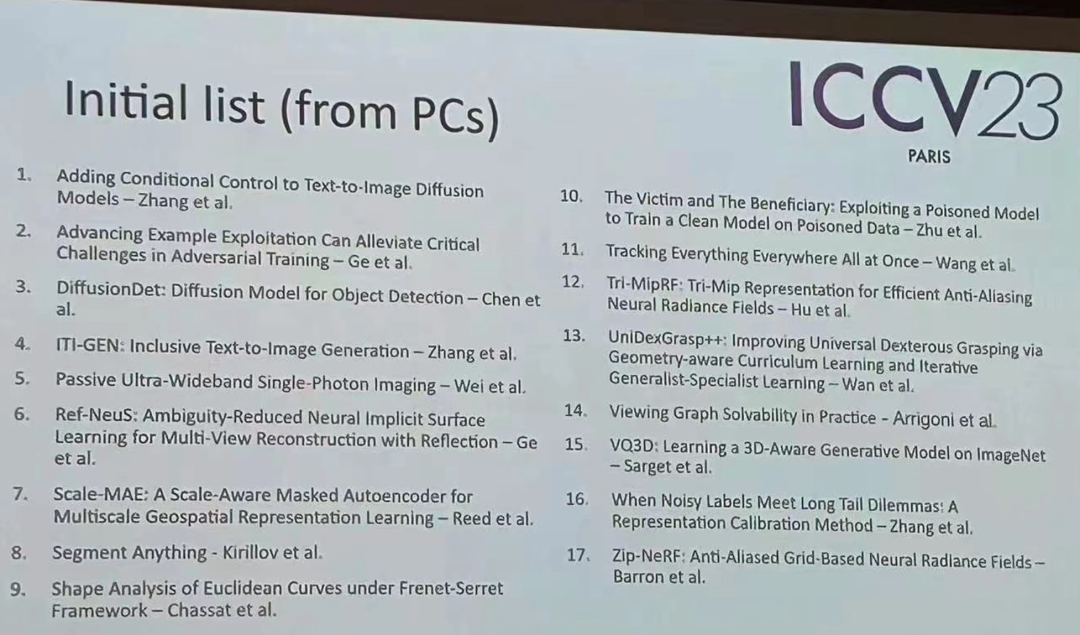

当然,除了这些获奖论文,今年 ICCV 还有许多优秀论文值得大家关注。最后为大家附上 17 篇获奖论文初始清单。

好了,关于ControlNet、「分割一切」等热门论文获奖,ICCV 2023论文奖项公布就讲到这。

版权及免责声明:凡本网所属版权作品,转载时须获得授权并注明来源“科技金融网”,违者本网将保留追究其相关法律责任的权力。凡转载文章,不代表本网观点和立场,如有侵权,请联系我们删除。

相关文章

- “尔森”用心倾听大自然的神秘邀约

- “考生”硕士统考发布报名提醒 考生需及时自查,抓紧时间修改

- “合肥市”“柿柿如意,柿如破竹”…… 高三学子“花式解压”

- “肌肉”磁铁刺激疗法可“对齐”肌肉纤维

- “低价”第15个双11:电商巨头争夺“最低价”、取消预售、开放生态

- “犯罪嫌疑人”湖南新化砍伤一对夫妇的犯罪嫌疑人落网,4人涉嫌窝藏罪被批捕

- “中国移动”中移动市场详情:合作伙伴大会重要发言及发布、反诈、5G应用获奖

- “血液”简单的血液检查调整可使重症监护治疗更安全

- “南充市”落马公安局长收受财物1365万被判7年:悔称利欲熏心,“金钱大厦”瞬间倾覆一生毁灭

- “高粱”河南固始有执法人员带人偷高粱?当地回应:涉事人员为行政执法大队人员,正调查

- “论文”获1000万美元捐款,用于代码重构、上云,论文预印版平台arXiv「好起来了」

- “红星”研究“嗑CP”论文走红网络,对话第一作者90后男生

- “论文”用ChatGPT伪造手稿,十几篇论文被曝光

- “蛋白质”浙大团队用深度学习方法进行高效、准确的大型文库配体对接,助力药物开发

- “论文”我国热点论文数量全球第一占比超45%

- “光学”“双非”高校首篇Nature!37岁一作花3个月写完初稿

- “样本”存放几十年老样本重见天日:科学家研发单细胞DNA测序法,可用于研究存档的癌症样本

- “导师”研究“她为什么换了导师”,华东师大一硕士学位论文走红

- “人类”师兄弟主动延毕,发《科学》论文“震惊人类”

- “论文”接收率26.1%,NeurIPS 2023录用结果出炉