“向量”单张图片引导,保留主体,风格百变,VCT帮你轻松实现

今天,很高兴为大家分享来自机器之心Pro的单张图片引导,保留主体,风格百变,VCT帮你轻松实现,如果您对单张图片引导,保留主体,风格百变,VCT帮你轻松实现感兴趣,请往下看。

近年来,图像生成技术取得了很多关键性突破。特别是自从 DALLE2、Stable Diffusion 等大模型发布以来,文本生成图像技术逐渐成熟,高质量的图像生成有了广阔的实用场景。然而,对于已有图片的细化编辑依旧是一个难题。

一方面,由于文本描述的局限性,现有的高质量文生图模型,只能利用文本对图片进行描述性的编辑,而对于某些具体效果,文本是难以描述的;另一方面,在实际应用场景中,图像细化编辑任务往往只有少量的参考图片,这让很多需要大量数据进行训练的方案,在少量数据,特别是只有一张参考图像的情况下,难以发挥作用。

最近,来自网易互娱 AI Lab 的研究人员提出了一种基于单张图像引导的图像到图像编辑方案,给定单张参考图像,即可把参考图中的物体或风格迁移到源图像,同时不改变源图像的整体结构。研究论文已被 ICCV 2023 接收,相关代码已开源。

论文地址:https://arxiv.org/abs/2307.14352

代码地址:https://github.com/CrystalNeuro/visual-concept-translator

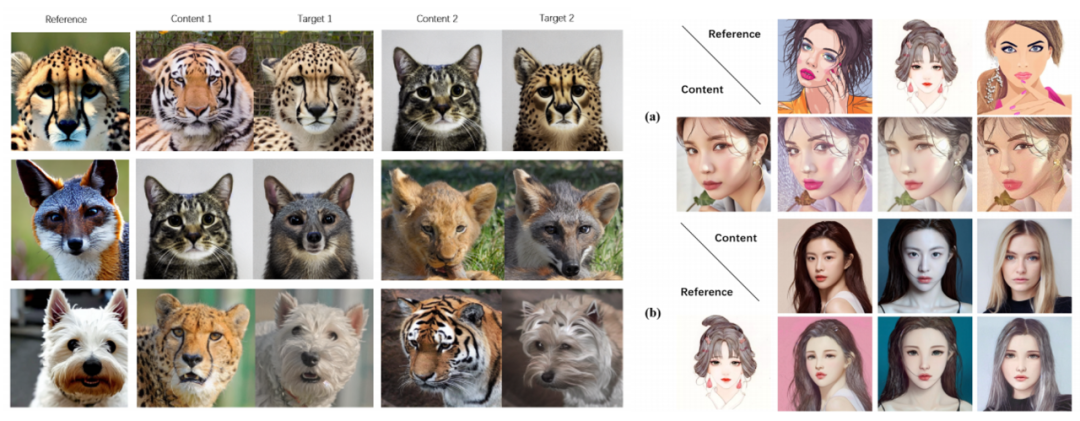

让我们先来看一组图,感受一下它的效果。

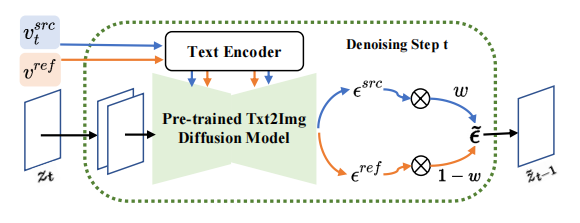

主体框架

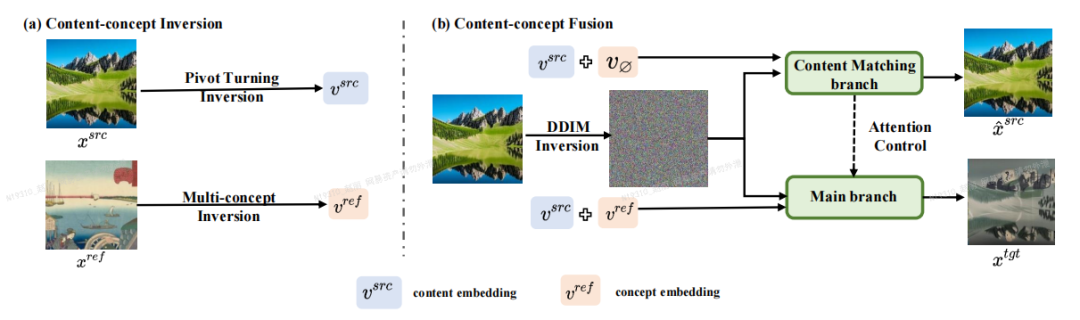

论文作者提出了一种基于反演-融合(Inversion-Fusion)的图像编辑框架 ——VCT(visual concept translator,视觉概念转换器)。如下图所示,VCT 的整体框架包括两个过程:内容-概念反演过程(Content-concept Inversion)和内容-概念融合过程(Content-concept Fusion)。内容 - 概念反演过程通过两种不同的反演算法,分别学习和表示原图像的结构信息和参考图像的语义信息的隐向量;内容-概念融合过程则将结构信息和语义信息的隐向量进行融合,生成最后的结果。

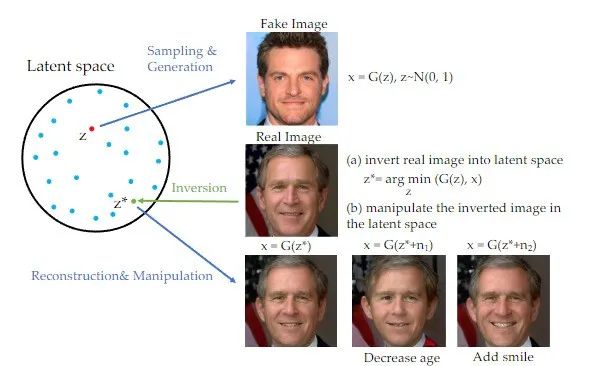

值得一提的是,反演方法是近年来,特别是在生成对抗网络(GAN)领域,广泛应用且在众多图像生成任务上取得突出效果的一项技术【1】。GAN Inversion 技术将一张图片映射到与训练的 GAN 生成器的隐空间中,通过对隐空间的控制来实现编辑的目的。反演方案可以充分利用预训练生成模型的生成能力。本研究实际上是将 GAN Inversion 技术迁移到了以扩散模型为先验的,基于图像引导的图像编辑任务上。

术【1】

方法介绍

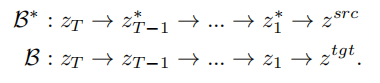

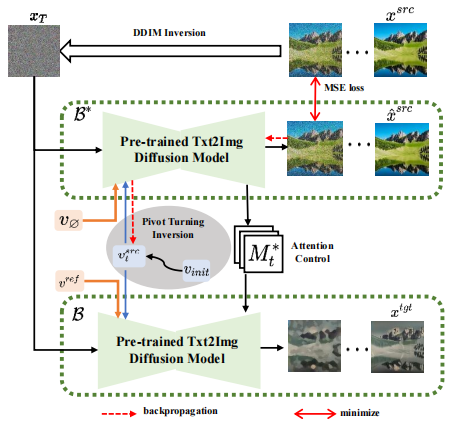

基于反演的思路,VCT 设计了一个双分支的扩散过程,其包含一个内容重建的分支 B* 和一个用于编辑的主分支 B。它们从同一个从 DDIM 反演(DDIM Inversion

【2】,一种利用扩散模型从图像计算噪声的算法)获得的噪声 xT 出发,分别用于内容重建和内容编辑。论文采用的预训练模型为隐向量扩散模型(Latent Diffusion Models,简称 LDM),扩散过程发生在隐向量空间 z 空间中,双分支过程可表示为:

内容重建分支 B* 学习 T 个内容特征向量

,用于还原原图的结构信息,并通过软注意力控制(soft attention control)的方案,将结构信息传递给编辑主分支 B。软注意力控制方案借鉴了谷歌的 prompt2prompt【3】工作,公式为:

即当扩散模型运行步数在一定区间时,将编辑主分支的注意力特征图替换内容重建分支的特征图,实现对生成图片的结构控制。编辑主分支 B 则融合从原图像学习的内容特征向量

,生成编辑的图片。

和从参考图像学习的概念特征向量

在扩散模型的每一步,特征向量的融合都发生在噪声空间空间,是特征向量输入扩散模型之后预测的噪声的加权。内容重建分支的特征混合发生在内容特征向量

和空文本向量上,与免分类器(Classifier-free)扩散引导【4】的形式一致:

编辑主分支的混合是内容特征向量

和概念特征向量

的混合,为

至此,研究的关键在于如何从单张源图片获取结构信息的特征向量

。文章分别通过两个不同的反演方案实现这一目的。

,和从单张参考图片获取概念信息的特征向量

为了复原源图片,文章参考 NULL-text【5】优化的方案,学习 T 个阶段的特征向量去匹配拟合源图像。但与 NULL-text 优化空文本向量去拟合 DDIM 路径不同的是,本文通过优化源图片特征向量,去直接拟合估计的干净特征向量,拟合公式为:

与学习结构信息不同的是,参考图像中的概念信息需要用单一高度概括的特征向量来表示,扩散模型的 T 个阶段共用一个概念特征向量

。文章优化了现有的反演方案 Textual Inversion【6】和 DreamArtist【7】。其采用一个多概念特征向量来表示参考图像的内容,损失函数包含一项扩散模型的噪声预估项和在隐向量空间的预估重建损失项:

实验结果

文章在主体替换和风格化任务上进行了实验,可以在较好地保持源图片的结构信息的情况下,将内容变成参考图片的主体或风格。

文章提出的 VCT 框架相较于以往的方案有以下优势:

(1)应用泛化性:与以往的基于图像引导的图像编辑任务相比,VCT 不需要大量的数据进行训练,且生成质量和泛化性更好。其基于反演的思路,以在开放世界数据预训练好的高质量文生图模型为基础,实际应用时,只需要一张输入图和一张参考图就可以完成较好的图片编辑效果。

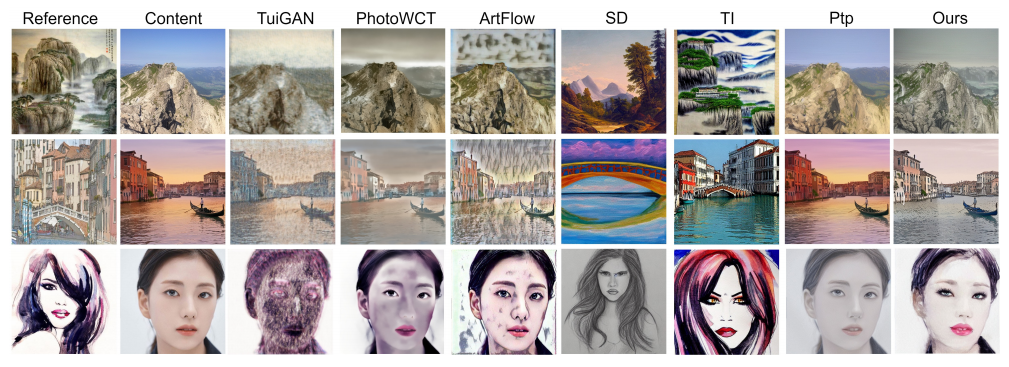

(2)视觉准确性:相较于近期文字编辑图像的方案,VCT 利用图片进行参考引导。图片参考相比于文字描述,可以更加准确地实现对图片的编辑。下图展示了 VCT 与其它方案的对比结果:

主体替换任务对比效果

主体替换任务对比效果 风格迁移任务对比效果

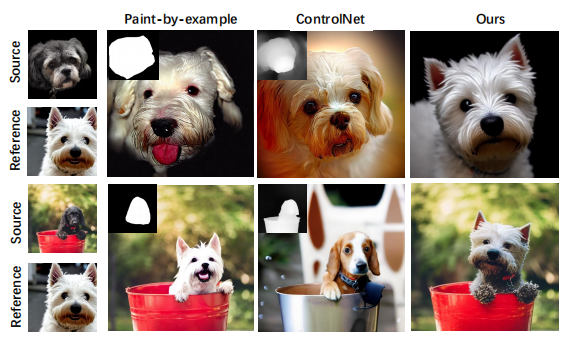

风格迁移任务对比效果(3)不需要额外信息:相较于近期的一些需要添加额外控制信息(如:遮罩图或深度图)等方案来进行引导控制的方案,VCT 直接从源图像和参考图像学习结构信息和语义信息来进行融合生成,下图是一些对比结果。其中,Paint-by-example 通过提供一个源图像的遮罩图,来将对应的物体换成参考图的物体;Controlnet 通过线稿图、深度图等控制生成的结果;而 VCT 则直接从源图像和参考图像,学习结构信息和内容信息融合成目标图像,不需要额外的限制。

基于图像引导的图像编辑方案的对比效果

基于图像引导的图像编辑方案的对比效果网易互娱 AI Lab

网易互娱 AI Lab 成立于 2017 年,隶属于网易互动娱乐事业群,是游戏行业领先的人工智能实验室。实验室致力于计算机视觉、语音和自然语言处理,以及强化学习等技术在游戏场景下的的研究和应用,旨在通过 AI 技术助力互娱旗下热门游戏及产品的技术升级,目前技术已应用于网易互娱旗下多款热门游戏,如《梦幻西游》、《哈利波特:魔法觉醒》、《阴阳师》、《大话西游》等等。

【1】Xia W, Zhang Y, Yang Y, et al. Gan inversion: A survey [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 45 (3): 3121-3138.

【2】 Song J, Meng C, Ermon S. Denoising Diffusion Implicit Models [C]//International Conference on Learning Representations. 2020.

【3】Hertz A, Mokady R, Tenenbaum J, et al. Prompt-to-Prompt Image Editing with Cross-Attention Control [C]//The Eleventh International Conference on Learning Representations. 2022.

【4】Jonathan Ho and Tim Salimans. Classifier-free diffusion guidance. In NeurIPS 2021 Workshop on Deep Generative Models and Downstream Applications

【5】Mokady R, Hertz A, Aberman K, et al. Null-text inversion for editing real images using guided diffusion models [C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2023: 6038-6047.

【6】Rinon Gal, Yuval Alaluf, Yuval Atzmon, Or Patash nik, Amit H Bermano, Gal Chechik, and Daniel Cohen Or. An image is worth one word: Personalizing text-to image generation using textual inversion. arXiv preprint arXiv:2208.01618, 2022

【7】Ziyi Dong, Pengxu Wei, and Liang Lin. Drea martist: Towards controllable one-shot text-to-image gen eration via contrastive prompt-tuning. arXiv preprintarXiv:2211.11337, 2022

好了,关于单张图片引导,保留主体,风格百变,VCT帮你轻松实现就讲到这。

版权及免责声明:凡本网所属版权作品,转载时须获得授权并注明来源“科技金融网”,违者本网将保留追究其相关法律责任的权力。凡转载文章,不代表本网观点和立场,如有侵权,请联系我们删除。

相关文章

- “小行星”我国2030年前后 实现载人登月

- “都是”A股的觉醒之年!

- “孩子”一生的功课

- “益康”倍益康上市几个月收入净利都大减 市值仅几亿 创始人张文有啥办法?

- “科幻”嘉宾共话科幻的未来:被视为“珍贵市场”,中国科幻正青春

- “灯会”红星观察|自贡灯会走出“春节舒适区”:首次试水中秋国庆主题灯会火出圈背后

- “华为”新麒麟全面替代!曝华为正在清理骁龙机型库存:掀起全线新品的“洪流”

- “鸟类”评论丨大楼玻璃贴膜防鸟撞,城市的天空如何助鸟自由飞翔?

- “同济大学”四川“无臂青年”彭超参与杭州亚残运会火炬传递,曾用脚写字考上同济大学研究生

- “模型”人工智能公司OpenCSG发布大模型开源生态社区“传神”

- “提示”ChatGPT与DALL·E 3之间的行业「黑话」被人发现了

- “图像”OpenAI终于Open一回:DALL-E 3论文公布、上线ChatGPT,作者一半是华人

- “模型”谷歌视觉语言模型PaLI-3问世,参数仅5B,更小、更快、更强

- “模型”清华团队攻破GPT-4V、谷歌Bard等模型,商用多模态大模型也脆弱?

- “人工智能”Adobe推出新图像生成工具

- “视觉”试过GPT-4V后,微软写了个166页的测评报告,业内人士:高级用户必读

- “图像”听说读写功能聚齐!ChatGPT迎来重大更新

- “语音”ChatGPT重磅更新!可以通过图片和语音命令交互

- “文本”无惧图像中的文字,TextDiffuser提供更高质量文本渲染

- “图像”OpenAI DALL·E 3来了,集成ChatGPT,生图效果太炸了