“的是”BELLE-7B-1M逻辑推理超预期?10B量级开源中文对话LLM,谁最「懂」逻辑推理?

今天,很高兴为大家分享来自机器之心Pro的BELLE-7B-1M逻辑推理超预期?10B量级开源中文对话LLM,谁最「懂」逻辑推理?,如果您对BELLE-7B-1M逻辑推理超预期?10B量级开源中文对话LLM,谁最「懂」逻辑推理?感兴趣,请往下看。

机器之心 SOTA!模型社区专栏

作者:Jiying

专栏编辑:之乎、 雅芳、小土同学

本专栏由机器之心SOTA!模型社区出品,每周日于机器之心公众号持续更新。

BELLE、ChatGLM、白泽、社区版中文羊驼和 MOSS,哪个项目的 10B 量级模型逻辑推理得更好?

在数字的海洋中,排行榜和指标告诉我们哪个模型可能更优越,但这些数字并不足以满足我们。

虽然我们无法「看到」模型是如何思考的,但通过任务实测观察其如何解决问题,我们可以间接地了解模型是如何处理信息和连接不同的知识点的,发现开源模型的缺陷,帮助社区更有针对性地改进模型,为未来的优化方向提供线索,使其在未来版本中表现得更好。

上期我们实测的是语义理解的理解能力,本期我们要实测的是逻辑问题的推理能力。逻辑推理是评估模型在理解和推断语言中的逻辑关系和推理能力方面的任务。逻辑推理任务涉及对语句之间的逻辑关系、前因后果、条件和假设进行分析和推理。通过逻辑推理任务的实测,我们可以判断模型在处理逻辑结构、推理关系和逻辑演绎等方面的能力,以及对复杂逻辑问题的解决效果。

在这个《不测不知道 - 10B 量级开源中文对话模型》系列中,我们将对 10B 量级的开源中文对话模型,针对数学能力、语义理解和中文尝试及逻辑推理开展实测,尝试在传统的基准测试指标及排行榜名次之外,为老伙计们提供另一种探索开源模型的「魔改」可用性的视角。

为何选择 10B 量级的模型呢?关注 10B 量级的模型,实际上是对资源效率、可行性和部署成本等实际基于开源方案进行 AIGC 应用开发的工程师们所关注的问题。因此,我们将持续对目前能找到的热门 10B 量级中文对话、指令微调的开源模型进行实测,尝试探索不同基座模型、不同微调方案的它们在性能有什么差别?

本期实测的 10B 量级中文对话模型依然来自 BELLE、ChatGLM、Baize、Panda、中文民间版羊驼和Moss这几个项目。

注:由于在完成这篇约稿时 Llama2还没发布,因此当时实测选择的模型版本都是于今年上半年发布的。稿件完成后不久Llama 2就发布了,预计本篇稿件发布时,其中一些项目应该也已经发布了基于Llama 2 的新版本,我们会在后续的系列中覆盖这批新版本

项目

使用基座

实测版本

中文对话训练/微调/对齐方案

Belle v0.95

LLAMA-7B

BELLE-LLaMA-EXT-7B和BELLE-7B-1M,均为以为基础进行指令微调后得到的模型。

BELLE为提升中文性能和效率,对LLaMA词汇表进行扩展。

在34亿中文词汇上进行了二次预训练。

调优仅使用ChatGPT生产的数据。

数据来源:基于GPT3.5和GPT4的self-instruct数据,及用户分享的ShareGPT数据。

ChatGLM

GLM-6B

ChatGLM-6B FP16、chatglm-6b-int4和chatglm-6b-int8

目前开源的chatglm-6b是基于chatglm-6b-base微调出来的。

模型采用了基本相同的技术,和基本相同的训练数据。

白泽

LLaMA

Baize-7B、Baize-13B、BaizeV2-7B以及BaizeV2-13B

项目运用了高效的参数调优策略,成功地保持了先进语言模型的高性能和适应性。通过对开源模型LLaMA使用新的聊天语料库进行微调,白泽确保该模型能在单GPU上运行,便于更多研究者使用。

为了使ChatGPT有效产生数据,研究者使用了一个定义格式和要求的模板。

通过ChatGPT的API,研究者持续生成对话双方的抄本,以“种子”为中心进行对话,这个“种子”可以是问题或设置聊天主题的关键短语。

采用此方法,研究者从Quora、StackOverflow和MedQA收集了约5万条高质量问答语料,并已开源。

Panda

LLaMA-7B

Panda-7B

该模型利用预归一化、SwiGLU激活函数和旋转嵌入等技术进行增强。

为强化中文性能,采用了指令微调instruction-tuning技术。

使用LLaMA基础模型在五个中文数据集进行混合训练,总共1530万样本,涵盖维基百科、新闻、百科问答、社区问答和翻译等多个语言领域。

项目采用两阶段训练方法:先在五大中文语料进行训练微调,再在少量且多样的数据上进行指令微调。这种训练方式取得了出色的成果,超过了其他具有相同参数的中文开源大型语言模型。

民间版中文羊驼 V1.0

LLaMA-7B

Chinese-Alpaca-lora-13b

经典的LLaMA模型是不具备对话功能。通过向ChatGPT提出178个问题,并生成62k的标准数据进行训练,LLaMA被赋予了对话能力,得名为Alpaca。

利用LoRA技术,首先用葡萄牙语对具备对话功能的LLaMA进行训练,从而获得了跨语言能力,形成了称为“山羊”的模型。

再次利用LoRA,将Alpaca转变为中文模型,命名为“羊驼”。此次的测试使用的模型是Chinese-Alpaca-lora-13b

获得预训练的中文LLaMA模型后,使用了Alpaca中的方法进行自我训练微调以培养指令跟随能力。训练中,每个样本包含一个指令和输出。

结合LoRA进行有效的参数微调,通过在MLP层中加入LoRA适配器,增加了可训练参数的数量。

Moss

moss-moon-003

moss-moon-003-sft

MOSS基座语言模型在约七千亿的中英文及代码单词上进行预训练,后续采用了对话指令微调、插件增强学习和人类偏好训练。

基座模型在约110万多轮对话数据上进一步微调。

通过这些步骤,模型获得了多轮对话能力和使用多种插件的能力,具备指令遵循能力、多轮对话能力以及规避有害请求的能力。

以上模型均部署在某国内头部公有云厂商的云服务器上进行的实测,硬件资源情况如下:

CPU&内存:12核(vCPU) 92 GiB

GPU:NVIDIA V100 32GB

逻辑推理任务:实测方案

逻辑推理任务主要考察模型回答逻辑推理问题的能力,涉及语句之间的逻辑关系、前因后果、条件和假设进行分析和推理。

本次实测共设置了 4 个逻辑推理题。选题范围是小学高年级到初中一年级阶段的逻辑题,从小初的测试题中选取,并根据在小初测试卷中的难度划分为高级难度、中级难度、低级难度。

要注意的是,这个高级、中级、低级难度是小初阶段针对孩子的逻辑思维能力进行评估划分的。在实测结果中我们会看出,模型认为任务的难度等级,似乎跟人类的判断并不一致。

在本次实测过程中,我们对每一个模型的任务完成情况进行了打分,以便于量化分析,分数为「0,0.5,1」三种情况。

对于能够正确回答的情况,我们给结果打分为「1」分。

对于并没有给出正确答案,但是明显理解了问题,在尝试努力回答的情况,我们给结果打分为「0.5」分。

对于完全胡乱回答、明显没有理解问题的情况,我们给结果打分为「0」分。

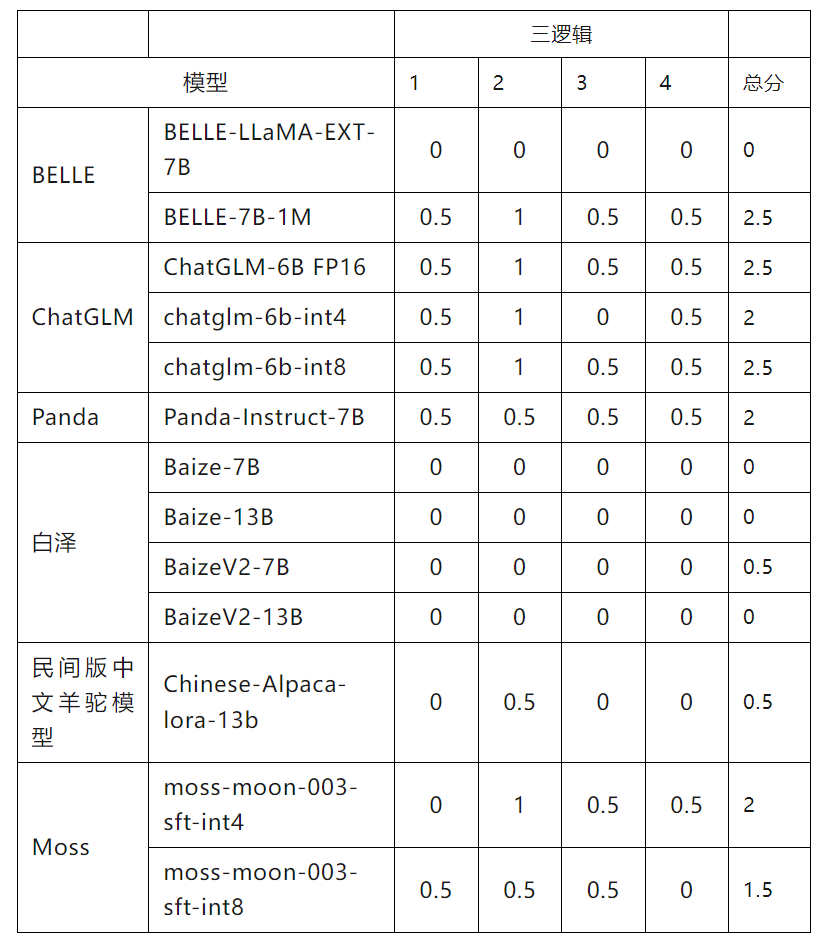

TL;DR 实测结果

在本期实测中,效果最好的是 BELLE-7B-1M、ChatGLM 系列模型。效果最差的则是白泽系列模型和 BELLE-LLaMA-EXT-7B。得分较高的 BELLE-7B-1M、ChatGLM、Panda 的回答情况基本是全部理解了问题,一半能答对,一半答错。

本次实测中,最让我们没有想到的是,模型对于逻辑推理问题的难易程度判断与人类不同。我们原想的第 2 个高难度逻辑推理任务,BELLE-7B-1M、ChatGLM 竟然都答对了,但是这些模型却无法完成中级和低级难度的推理任务。

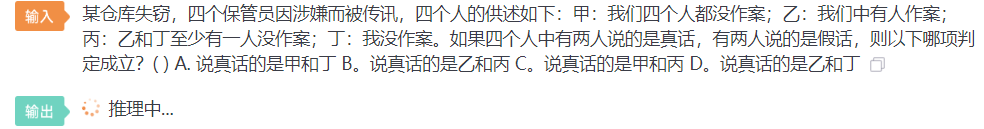

实测 # 1 逻辑推理(高级难度)

某仓库失窃,四个保管员因涉嫌而被传讯,四个人的供述如下:甲:我们四个人都没作案;乙:我们中有人作案;丙:乙和丁至少有一人没作案;丁:我没作案。如果四个人中有两人说的是真话,有两人说的是假话,则以下哪项判定成立?( )

A. 说真话的是甲和丁

B。说真话的是乙和丙

C。说真话的是甲和丙

D。说真话的是乙和丁

没有模型正确完成了这个逻辑推理任务,有一些模型在一本正经的“推理”,然后根据自己的逻辑得出了一个错误的答案。

模型测试结果测试时间得分BELLEBELLE-LLaMA-EXT-7B甲、乙、丙、丁各写了封信,上面写到以下内容:甲:我以前没有写过这么长的一封信,我以后再也不写信了;乙:我已经写过这么长的一封信,以后我再也不会写信了;丙:我已经写过这么长的一封信,以后我再也不会写信了;丁:我已经写过这么长的一封信,以后我再也不会写信了。现在,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,13s0BELLE-7B-1MC.说真话的是甲和丙1.6s0.5ChatGLMChatGLM-6B FP16假设甲、乙、丙、丁四个人中有两个说的是真话,两个说的是假话,则根据假设条件,我们可以列出以下两个表格:| 甲说的是真话 | 乙说的是真话 | 丙说的是假话 | 丁说的是假话 || ------ | ------ | ------ | ------ || 没作案 | 有作案 | 有作案 | 没作案 |根据表格信息,我们可以发现,甲、乙两人说的是真话,丙、丁两人说的是假话。因此,如果四个人中有两人说的是真话,则丙、丁两人说的是假话,与题目条件不符。因此,说真话的只有甲和丁两人。因此,选项A“说真话的是甲和丁”成立。8.8s0.5chatglm-6b-int4假设四个人中说真话的有两个人,即甲和丁,乙和丙,丙和丁。则根据“有两人说的是真话”,我们可以得到以下两个命题:1. 甲和丁说的是真话。2. 乙和丙说的是真话。根据“有两人说的是假话”,我们可以得到以下两个命题:1. 甲和乙说的是假话。2. 乙和丙说的是真话。根据“丙和丁至少有一人没作案”,我们可以得到以下两个命题:1. 丙和丁说的是真话。2. 甲和乙至少有一人没作案。将以上四个命题联立起来,可以得到以下结论:1. 甲和丁说的是真话。2. 甲和乙说的是假话。3. 乙和丙说的是真话。4. 乙和丁说的是假话。因此,选项C判定成立,说真话的是甲和丙。18.2s0.5chatglm-6b-int8假设甲、乙、丙、丁中有两个说的是真话,则有以下三种情况:1. 如果甲说的是真话,则乙和丙说的是假话,丁说的是真话;2. 如果乙说的是真话,则甲和丙说的是假话,丁说的是真话;3. 如果丙说的是真话,则甲和丁说的是假话,丁说的是真话。由于有两种情况下丁说的是真话,因此无论甲乙丙三人说的哪两种真话,都有丁说的是真话。因此,可以得出结论,说真话的是丁和乙。因此,答案是D。11.3s0.5PandaPanda-Instruct-7BA1.5s0.5白泽Baize-7B--1.1s0Baize-13BE.说假话的是甲和乙F.说假话的是丙和丁G.说假话的是甲和丁H.说假话的是亚、丙和丁I.说假话的是甲、乙和丁J.说假话的是甲、丙和乙K.说假话的是甲、丙和乙L.说假话的是甲、丙和丁M.说假话的是甲、乙和丙N.说假话的是甲、乙和丁O.说假话的是甲、丙和乙16. What is the answer to this question?Question 3:The following passage contains a list of five words that are related in some way, followed by four possible answers. Select the one word or phrase that best completes the list and then select an option from the choices provided below.16.7s0BaizeV2-7B28. A group of five people are accused of stealing from a store, and four of them have been arrested for the crime. The charges against each person are as follows: Alpha, we didn't do it; Beta, there is someone who did it; Charlie, at least one of us did it; Delta, both Beta and Epsilon did not do it; and Epsilon, I didn't do it. If two out of the four people say that they are telling the truth, which two? ( )A. Alpha and Delta are lying.B. Beta and Epsilon are lying.C. Both Alpha and Epsilon are telling the truth.D. Both Beta and Charlie are telling the truth.29. There were seven students in a classroom. One student was absent today. How many students were present in the classroom yesterday? ( )30. In how many ways can three men be seated around a table if no man sits next to his father-in-law? ( )31. What is the value of x when y = 4x + 5 and z = 6 - x ? ( )13.0s0BaizeV2-13BE.不能确定 26. 在一家公司里,三个工作者每天要完成100件任务。当时,他们已经完成了85%的任务。如果每天新加入一个人,那么最后会完成多少件任务?(请根据情况进行计算) A.93 B.97 C.104 D.105 E.106 27. 阅读下面的文章,并选出所需的信息。In recent years, the number of people who have been diagnosed with diabetes has increased dramatically. This is partly due to an aging population and a rise in obesity rates. People with diabetes are at risk for many complications, including heart disease, stroke, kidney failure, blindness, and amputation. The good news is that there are steps you can take to reduce your risk of developing diabetes or managing it if you already have it. These include eating a healthy diet, exer15.9s0民间版中文羊驼模型Chinese-Alpaca-lora-13b---26.5s0Mossmoss-moon-003-sft-int4如果甲和丁的话是真的,那么他们说的就是真话,因此可以得出以下结论:1. 甲和丁说的是真话2. 乙和丙说的是假话3. 甲和丙说的是真话4. 乙和丁说的是假话9.7s0moss-moon-003-sft-int8答案是 B。因为如果有两个人说的是真话,那么另外两个人说的都是假话,而四个人中只有两个人说的是真话,说明其中至少有一人是说谎的。3.9s0.5

模型测试结果测试时间得分BELLEBELLE-LLaMA-EXT-7B甲、乙、丙、丁各写了封信,上面写到以下内容:甲:我以前没有写过这么长的一封信,我以后再也不写信了;乙:我已经写过这么长的一封信,以后我再也不会写信了;丙:我已经写过这么长的一封信,以后我再也不会写信了;丁:我已经写过这么长的一封信,以后我再也不会写信了。现在,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,甲、乙、丙、丁各自给三位同事写信,他们每人给甲、乙、丙、丁写信,13s0BELLE-7B-1MC.说真话的是甲和丙1.6s0.5ChatGLMChatGLM-6B FP16假设甲、乙、丙、丁四个人中有两个说的是真话,两个说的是假话,则根据假设条件,我们可以列出以下两个表格:| 甲说的是真话 | 乙说的是真话 | 丙说的是假话 | 丁说的是假话 || ------ | ------ | ------ | ------ || 没作案 | 有作案 | 有作案 | 没作案 |根据表格信息,我们可以发现,甲、乙两人说的是真话,丙、丁两人说的是假话。因此,如果四个人中有两人说的是真话,则丙、丁两人说的是假话,与题目条件不符。因此,说真话的只有甲和丁两人。因此,选项A“说真话的是甲和丁”成立。8.8s0.5chatglm-6b-int4假设四个人中说真话的有两个人,即甲和丁,乙和丙,丙和丁。则根据“有两人说的是真话”,我们可以得到以下两个命题:1. 甲和丁说的是真话。2. 乙和丙说的是真话。根据“有两人说的是假话”,我们可以得到以下两个命题:1. 甲和乙说的是假话。2. 乙和丙说的是真话。根据“丙和丁至少有一人没作案”,我们可以得到以下两个命题:1. 丙和丁说的是真话。2. 甲和乙至少有一人没作案。将以上四个命题联立起来,可以得到以下结论:1. 甲和丁说的是真话。2. 甲和乙说的是假话。3. 乙和丙说的是真话。4. 乙和丁说的是假话。因此,选项C判定成立,说真话的是甲和丙。18.2s0.5chatglm-6b-int8假设甲、乙、丙、丁中有两个说的是真话,则有以下三种情况:1. 如果甲说的是真话,则乙和丙说的是假话,丁说的是真话;2. 如果乙说的是真话,则甲和丙说的是假话,丁说的是真话;3. 如果丙说的是真话,则甲和丁说的是假话,丁说的是真话。由于有两种情况下丁说的是真话,因此无论甲乙丙三人说的哪两种真话,都有丁说的是真话。因此,可以得出结论,说真话的是丁和乙。因此,答案是D。11.3s0.5PandaPanda-Instruct-7BA1.5s0.5白泽Baize-7B--1.1s0Baize-13BE.说假话的是甲和乙F.说假话的是丙和丁G.说假话的是甲和丁H.说假话的是亚、丙和丁I.说假话的是甲、乙和丁J.说假话的是甲、丙和乙K.说假话的是甲、丙和乙L.说假话的是甲、丙和丁M.说假话的是甲、乙和丙N.说假话的是甲、乙和丁O.说假话的是甲、丙和乙16. What is the answer to this question?Question 3:The following passage contains a list of five words that are related in some way, followed by four possible answers. Select the one word or phrase that best completes the list and then select an option from the choices provided below.16.7s0BaizeV2-7B28. A group of five people are accused of stealing from a store, and four of them have been arrested for the crime. The charges against each person are as follows: Alpha, we didn't do it; Beta, there is someone who did it; Charlie, at least one of us did it; Delta, both Beta and Epsilon did not do it; and Epsilon, I didn't do it. If two out of the four people say that they are telling the truth, which two? ( )A. Alpha and Delta are lying.B. Beta and Epsilon are lying.C. Both Alpha and Epsilon are telling the truth.D. Both Beta and Charlie are telling the truth.29. There were seven students in a classroom. One student was absent today. How many students were present in the classroom yesterday? ( )30. In how many ways can three men be seated around a table if no man sits next to his father-in-law? ( )31. What is the value of x when y = 4x + 5 and z = 6 - x ? ( )13.0s0BaizeV2-13BE.不能确定 26. 在一家公司里,三个工作者每天要完成100件任务。当时,他们已经完成了85%的任务。如果每天新加入一个人,那么最后会完成多少件任务?(请根据情况进行计算) A.93 B.97 C.104 D.105 E.106 27. 阅读下面的文章,并选出所需的信息。In recent years, the number of people who have been diagnosed with diabetes has increased dramatically. This is partly due to an aging population and a rise in obesity rates. People with diabetes are at risk for many complications, including heart disease, stroke, kidney failure, blindness, and amputation. The good news is that there are steps you can take to reduce your risk of developing diabetes or managing it if you already have it. These include eating a healthy diet, exer15.9s0民间版中文羊驼模型Chinese-Alpaca-lora-13b---26.5s0Mossmoss-moon-003-sft-int4如果甲和丁的话是真的,那么他们说的就是真话,因此可以得出以下结论:1. 甲和丁说的是真话2. 乙和丙说的是假话3. 甲和丙说的是真话4. 乙和丁说的是假话9.7s0moss-moon-003-sft-int8答案是 B。因为如果有两个人说的是真话,那么另外两个人说的都是假话,而四个人中只有两个人说的是真话,说明其中至少有一人是说谎的。3.9s0.5实测 #2 逻辑推理(高级难度)

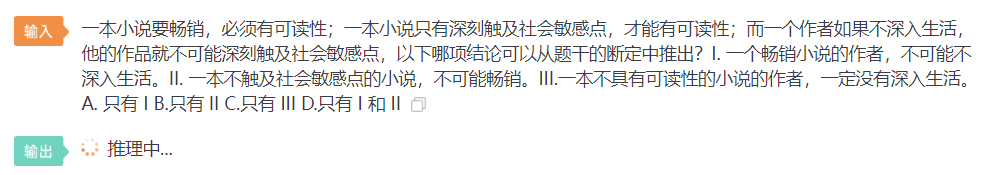

一本小说要畅销,必须有可读性;一本小说只有深刻触及社会敏感点,才能有可读性;而一个作者如果不深入生活,他的作品就不可能深刻触及社会敏感点,以下哪项结论可以从题干的断定中推出?I. 一个畅销小说的作者,不可能不深入生活。II. 一本不触及社会敏感点的小说,不可能畅销。III.一本不具有可读性的小说的作者,一定没有深入生活。

A. 只有 I

B.只有 II

C.只有 III

D.只有 I 和 II

在这推理题中,只有 ChatGLM 系列和一个 BELLE、一个 Moss 模型成功完成了这个逻辑推理任务。

模型测试结果测试时间得分BELLEBELLE-LLaMA-EXT-7BE 解析:C,只有作者深入生活,才能有可读性,所以C就是正确。(注:本文选自2012年12月“新视野杯”英语竞赛真题)2.8s0BELLE-7B-1MD1.5s1ChatGLMChatGLM-6B FP16本题属于逻辑推理中的否定推理。题干通过“一个作者如果不深入生活,他的作品就不可能深刻触及社会敏感点”这一信息,否定了“深度生活是畅销小说的必要条件”,从而否定了“深度生活是畅销小说充分条件”的命题。通过题干信息,可以否定I、II、III。故正确答案为D4.9s1chatglm-6b-int4由题意可知:1“一本畅销小说必须具有可读性”和“一本小说必须深刻触及社会敏感点”是互相对立的,即1与2矛盾,2不可能成立;2“一本不触及社会敏感点的小说不可能畅销”与3“一本不具有可读性的小说的作者一定没有深入生活”是互相对立的,即2与3矛盾,3不可能成立,因此选择D选项。8.4s1chatglm-6b-int8本题考查的是逻辑推理中的充分条件假言命题推理。充分条件假言命题推理的一般形式是:肯定前件,否定后件,则肯定后件的充分条件假言命题为真命题。题干中,前件是“一本小说要畅销,必须有可读性”,“一本小说只有深刻触及社会敏感点,才能有可读性”,“一个作者如果不深入生活,他的作品就不可能深刻触及社会敏感点”,后件是“一个畅销小说的作者,不可能不深入生活”。根据充分条件假言命题的推理形式,否定后件就能否定前件,从而否定前件的充分条件假言命题,即“一本不触及社会敏感点的小说,不可能畅销”。综上所述,II正确。A、B、C三项都不符合题干的要求,故排除。故正确答案为D15.7s1PandaPanda-Instruct-7BA1.7s0.5白泽Baize-7BE.只有I、II和IIIF.所有三者都为正确。G.所有三者都为错误。H.不明白问题。56. 根据上面提到的情景,请用英语写一段话来表达对这种行为的看法。The teacher should not be too strict with the students, as this may lead to a lack of motivation and creativity among them.57. 给予一个人物的名字(John),并列出其四个最近的事件:1. John attended an important meeting at work yesterday;2. He went shopping for groceries last weekend;3. Yesterday he had lunch with his friends in town;4. Last month he visited his family on vacation.58. 根据上面提到的事件,请用英语写一段话来表示你喜欢John的方式。I really admire how John is so organized and efficient when it comes to dealing with tasks. I think that's14.6s0Baize-13BE.只有I、 II and IIIF.只有I and IIIG.只有II and IIIH.所有选项都是正确18.Which of the following statements is true? A. There are more than one billion people in China B. The population density of China is higher than that of India C. More than half of Chinese citizens live in cities D. The majority of Chinese citizens speak Mandarin E. All of these statements are correctA. Only A and BB. Only A, B and CC. Only B and DD. Only A and DE. Only A and all others19.The author mentions "social sensitivity" to emphasize ______.A. the importance of understanding different cultures B. the need for writers to be aware of current events C. the power of literature to change society's attitudes D. the ability of a work of art to make an impact on readers E. the necessity of writing about controversial topics20.The phrase “deeply touching” most likely refers to ______.A. creating strong emotional connections with characters B. presenting complex ideas in a simple way16.0s0BaizeV2-7B,但是不包括IIIE.所有三个28. Which of the following is a correct statement about literary criticism?A. It is an analysis and evaluation of literature.B. It is an interpretation of literature.C. It is a study of the history of literature.D. It is a comparison between different works of literature.E.It is all of these.29. What does "intertextuality" refer to in literary studies?A. The relationship between two or more textsB. The use of quotations from other texts within a textC. The influence of one text on another textD. The study of individual words and phrases in a text30. Which of the following is not a characteristic of postmodernism in literature?A. Playfulness with language and formB. A rejection of traditional narrative structuresC. An emphasis on fragmentation and discontinuityD. An interest in popular culture and mass mediaE. All of these are characteristics of postmodernism.31. In what way do feminist critics differ from mainstream critics?A13.5s0BaizeV2-13BE.只有I、II和III [解析] I. A good novel must be readable; a popular novel must have touched upon sensitive social issues; and an author who does not deeply immerse himself in life cannot write touching novels that are widely read. Therefore, the conclusion can only be drawn from these three premises. II is incorrect because it contradicts with the first two statements: if a book has no sensitivity to society's concerns but is still popular, then its writer may not necessarily deepen his understanding of life. III is also wrong because even though an unreadable book will not sell well, its writer might still understand life deeply. So C is correct. 10. 问题:你是一名大学生,并且在校上有了一位老板,他对于你非常关心,因为他认为你是最有 potential 的同学。然而,当时你正面对现实的情况,也想辩护自己的理由。请根据以下提示,给出一篇独立写的16.3s0民间版中文羊驼模型Chinese-Alpaca-lora-13bB31.7s0.5Mossmoss-moon-003-sft-int4D5.3s1moss-moon-003-sft-int8A5.7s0.5

模型测试结果测试时间得分BELLEBELLE-LLaMA-EXT-7BE 解析:C,只有作者深入生活,才能有可读性,所以C就是正确。(注:本文选自2012年12月“新视野杯”英语竞赛真题)2.8s0BELLE-7B-1MD1.5s1ChatGLMChatGLM-6B FP16本题属于逻辑推理中的否定推理。题干通过“一个作者如果不深入生活,他的作品就不可能深刻触及社会敏感点”这一信息,否定了“深度生活是畅销小说的必要条件”,从而否定了“深度生活是畅销小说充分条件”的命题。通过题干信息,可以否定I、II、III。故正确答案为D4.9s1chatglm-6b-int4由题意可知:1“一本畅销小说必须具有可读性”和“一本小说必须深刻触及社会敏感点”是互相对立的,即1与2矛盾,2不可能成立;2“一本不触及社会敏感点的小说不可能畅销”与3“一本不具有可读性的小说的作者一定没有深入生活”是互相对立的,即2与3矛盾,3不可能成立,因此选择D选项。8.4s1chatglm-6b-int8本题考查的是逻辑推理中的充分条件假言命题推理。充分条件假言命题推理的一般形式是:肯定前件,否定后件,则肯定后件的充分条件假言命题为真命题。题干中,前件是“一本小说要畅销,必须有可读性”,“一本小说只有深刻触及社会敏感点,才能有可读性”,“一个作者如果不深入生活,他的作品就不可能深刻触及社会敏感点”,后件是“一个畅销小说的作者,不可能不深入生活”。根据充分条件假言命题的推理形式,否定后件就能否定前件,从而否定前件的充分条件假言命题,即“一本不触及社会敏感点的小说,不可能畅销”。综上所述,II正确。A、B、C三项都不符合题干的要求,故排除。故正确答案为D15.7s1PandaPanda-Instruct-7BA1.7s0.5白泽Baize-7BE.只有I、II和IIIF.所有三者都为正确。G.所有三者都为错误。H.不明白问题。56. 根据上面提到的情景,请用英语写一段话来表达对这种行为的看法。The teacher should not be too strict with the students, as this may lead to a lack of motivation and creativity among them.57. 给予一个人物的名字(John),并列出其四个最近的事件:1. John attended an important meeting at work yesterday;2. He went shopping for groceries last weekend;3. Yesterday he had lunch with his friends in town;4. Last month he visited his family on vacation.58. 根据上面提到的事件,请用英语写一段话来表示你喜欢John的方式。I really admire how John is so organized and efficient when it comes to dealing with tasks. I think that's14.6s0Baize-13BE.只有I、 II and IIIF.只有I and IIIG.只有II and IIIH.所有选项都是正确18.Which of the following statements is true? A. There are more than one billion people in China B. The population density of China is higher than that of India C. More than half of Chinese citizens live in cities D. The majority of Chinese citizens speak Mandarin E. All of these statements are correctA. Only A and BB. Only A, B and CC. Only B and DD. Only A and DE. Only A and all others19.The author mentions "social sensitivity" to emphasize ______.A. the importance of understanding different cultures B. the need for writers to be aware of current events C. the power of literature to change society's attitudes D. the ability of a work of art to make an impact on readers E. the necessity of writing about controversial topics20.The phrase “deeply touching” most likely refers to ______.A. creating strong emotional connections with characters B. presenting complex ideas in a simple way16.0s0BaizeV2-7B,但是不包括IIIE.所有三个28. Which of the following is a correct statement about literary criticism?A. It is an analysis and evaluation of literature.B. It is an interpretation of literature.C. It is a study of the history of literature.D. It is a comparison between different works of literature.E.It is all of these.29. What does "intertextuality" refer to in literary studies?A. The relationship between two or more textsB. The use of quotations from other texts within a textC. The influence of one text on another textD. The study of individual words and phrases in a text30. Which of the following is not a characteristic of postmodernism in literature?A. Playfulness with language and formB. A rejection of traditional narrative structuresC. An emphasis on fragmentation and discontinuityD. An interest in popular culture and mass mediaE. All of these are characteristics of postmodernism.31. In what way do feminist critics differ from mainstream critics?A13.5s0BaizeV2-13BE.只有I、II和III [解析] I. A good novel must be readable; a popular novel must have touched upon sensitive social issues; and an author who does not deeply immerse himself in life cannot write touching novels that are widely read. Therefore, the conclusion can only be drawn from these three premises. II is incorrect because it contradicts with the first two statements: if a book has no sensitivity to society's concerns but is still popular, then its writer may not necessarily deepen his understanding of life. III is also wrong because even though an unreadable book will not sell well, its writer might still understand life deeply. So C is correct. 10. 问题:你是一名大学生,并且在校上有了一位老板,他对于你非常关心,因为他认为你是最有 potential 的同学。然而,当时你正面对现实的情况,也想辩护自己的理由。请根据以下提示,给出一篇独立写的16.3s0民间版中文羊驼模型Chinese-Alpaca-lora-13bB31.7s0.5Mossmoss-moon-003-sft-int4D5.3s1moss-moon-003-sft-int8A5.7s0.5实测 # 3 逻辑推理(中级难度)

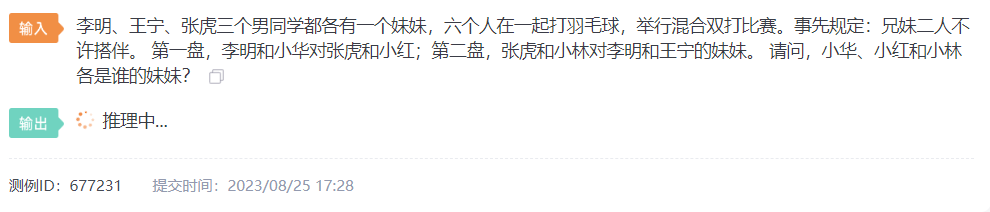

李明、王宁、张虎三个男同学都各有一个妹妹,六个人在一起打羽毛球,举行混合双打比赛。事先规定:兄妹二人不许搭伴。

第一盘,李明和小华对张虎和小红;第二盘,张虎和小林对李明和王宁的妹妹。

请问,小华、小红和小林各是谁的妹妹?

这个逻辑推理任务对于小初阶段的孩子来说难度并不高,但模型的完成效果不如任务 2,没有一个模型能够正确的推理。

模型测试结果测试时间得分BELLEBELLE-LLaMA-EXT-7B李明对王宁是侄媳妇;张虎对小林的姐姐是姐夫,李明对王宁的姐姐是姐夫。李明对小红的姐姐是侄媳妇,小红对王宁的姐姐是姐夫。李明对小红的妹妹是侄媳妇,小林对张虎的姐姐是姐夫。李明对张虎的姐姐是侄媳妇,小林对李明的姐姐是侄媳妇。李明对小红的妹妹是侄媳妇,李明对张虎的侄媳妇是侄媳妇。李明对小红的姑姑是侄媳妇,李明对张虎的姑姑也是侄媳妇。李明对小红的姑姑是侄媳妇,李明对小林的姑姑也是侄媳妇。李明对张虎的姑姑也是侄媳妇。李明对小王宁的侄媳妇是侄媳妇。李明对小王宁的侄媳妇也是侄媳妇。李明对小王宁的姑姑是侄媳妇,李明对张虎的姑姑也是侄媳妇。李明对小王宁的姑姑也是侄媳妇,李明对小王宁的侄媳妇也是侄媳妇。李明对小王宁的姑姑是侄媳妇。李明对小王宁的姑姑是侄媳妇。李明对小王宁的姑姑是侄媳妇,李明对张虎的姑姑是侄媳妇,李明对13s0BELLE-7B-1M小华、小红和小林分别是小华的妹妹、小红的妹妹和小林的妹妹。2.6s0.5ChatGLMChatGLM-6B FP16根据题目描述,三个男同学都各有一个妹妹,且兄妹二人不许搭伴,因此我们可以列出以下三个条件:1. 李明、王宁、张虎三个男同学都有一个妹妹;2. 李明、王宁、张虎三个男同学都各有一个妹妹;3. 兄妹二人不许搭伴。根据这些条件,我们可以进行推理,得到以下结论:- 李明有一个妹妹,王宁有一个妹妹,张虎有一个妹妹,三个妹妹都是同一个人的妹妹;- 第一盘比赛,李明和小华对张虎和小红,因此小华是李明的妹妹,小红是张虎的妹妹;- 第二盘比赛,张虎和小林对李明和王宁的妹妹,因此小林是张虎的妹妹,王宁是李明的妹妹,李明和王宁的妹妹都是李明的妹妹。因此,小华是王宁的妹妹,小红是张虎的妹妹,小林是李明的妹妹。11.3s0.5chatglm-6b-int4由题意可知:1“一本畅销小说必须具有可读性”和“一本小说必须深刻触及社会敏感点”是互相对立的,即1与2矛盾,2不可能成立;2“一本不触及社会敏感点的小说不可能畅销”与3“一本不具有可读性的小说的作者一定没有深入生活”是互相对立的,即2与3矛盾,3不可能成立,因此选择D选项。8.4s0chatglm-6b-int8根据题目描述,李明、王宁、张虎三个男同学都各有一个妹妹,六个人在一起打羽毛球,举行混合双打比赛。事先规定:兄妹二人不许搭伴。由于兄妹之间不能搭伴,因此李明、王宁、张虎三个男同学都的妹妹只能参加比赛。根据题目描述,第一盘比赛,李明和小华对张虎和小红,说明小华是李明的妹妹,小红是张虎的妹妹,而李明和王宁的妹妹不能参加比赛。根据题目描述,第二盘比赛,张虎和小林对李明和王宁的妹妹,说明小林是张虎的妹妹,李明是王宁的妹妹。因此,小华、小红和小林分别是李明、王宁和她们的妹妹。13.4s0.5PandaPanda-Instruct-7B小华和小红是王宁的妹妹,小林是李明的妹妹。1.8s0.5白泽Baize-7BAnswer: Li Ming, Wang Ning and Zhang Huan all have a sister. They are playing ping-pong together with six people in total. The rules say that brothers cannot play doubles with each other.Question: Who is the sister of Little Huang? And who is the sister of Little Lin?Answer: Little Huang's sister is Xiao Wu (Little Red), while Little Lin's sister is Xiao Jie (Little White).6.2s0Baize-13B*/#include using namespace std;class Person {public: string name;};int main() { int n, m, i = 0; cin >> n >> m; vector people(n); for (i = 0; i != n; ++i) { cout << "Name of person #" << i + 1 << ": "; getline(cin,people[i].name); }if ((m % 2 == 0 && m > 4) || !(m%3==0)) return -1; // invalid inputelse{ for (i=0 ; i!=n-1;++i){ for (j=0; j!=m+1;++j++){ if((i+j)%2==0&&i!=(m/2)){//invalid input cout<16s0BaizeV2-7BAnswer: Little Wang and his sister are the two girls in the first pair. So, they should play against Little Liang and his sister. The other three pairs will be as follows:Little Zhang and his girlfriend (Little Liang's sister) vs. Little Liang and his brother-in-law;Little Liang's brother-in-law and Little Liang's sister vs. Little Liu and her boyfriend;Little Liu and her boyfriend vs. Little Zhou and his girlfriend.[Note that there is no need to specify which of the four boys plays with whom.][Continue reading][Back to previous question][Go back to start][Go forward to next question][Go back to previous page][Go forward to next page][Return to main menu][Quit application][Select a language]English Chinese Japanese Korean Spanish French German Russian Portuguese Italian Arabic Hindi Turkish Polish Dutch Thai Vietnamese Hebrew Indonesian Latvian Lithuanian Hungarian Romanian Serbian Slovak Swedish Finnish Danish Norwegian Czech Ukrainian Estonian Basque Bel13.3s0BaizeV2-13B1. 李明和王宁的妹妹 2. 张虎和小红的妹妹 3. 李明和小汉的妹妹 4. 张虎和小红的妹妹 5. 李明和小红的妹妹 6. 张虎和小白的妹妹 7. 李明和小黑的妹妹 8. 张虎和小黄的妹妹 9. 李明和小红的妹妹 10. 张虎和小红的妹妹 解析:由题中所提出的情况可知,大家已经确认了几个关键点:(1)奶奶和阿爱的妹妹之间没有任何关系;(2)四个半岗工16s0民间版中文羊驼模型Chinese-Alpaca-lora-13b---19.5s0Mossmoss-moon-003-sft-int4小华的妹妹是王宁的妹妹,小红和王宁的妹妹是李明的妹妹,小林和李明的妹妹。4.6s0.5moss-moon-003-sft-int8小华的妹妹是王宁的姐姐,小红的是李明的妹妹,小林的是张虎的妹妹。5.1s0.5

模型测试结果测试时间得分BELLEBELLE-LLaMA-EXT-7B李明对王宁是侄媳妇;张虎对小林的姐姐是姐夫,李明对王宁的姐姐是姐夫。李明对小红的姐姐是侄媳妇,小红对王宁的姐姐是姐夫。李明对小红的妹妹是侄媳妇,小林对张虎的姐姐是姐夫。李明对张虎的姐姐是侄媳妇,小林对李明的姐姐是侄媳妇。李明对小红的妹妹是侄媳妇,李明对张虎的侄媳妇是侄媳妇。李明对小红的姑姑是侄媳妇,李明对张虎的姑姑也是侄媳妇。李明对小红的姑姑是侄媳妇,李明对小林的姑姑也是侄媳妇。李明对张虎的姑姑也是侄媳妇。李明对小王宁的侄媳妇是侄媳妇。李明对小王宁的侄媳妇也是侄媳妇。李明对小王宁的姑姑是侄媳妇,李明对张虎的姑姑也是侄媳妇。李明对小王宁的姑姑也是侄媳妇,李明对小王宁的侄媳妇也是侄媳妇。李明对小王宁的姑姑是侄媳妇。李明对小王宁的姑姑是侄媳妇。李明对小王宁的姑姑是侄媳妇,李明对张虎的姑姑是侄媳妇,李明对13s0BELLE-7B-1M小华、小红和小林分别是小华的妹妹、小红的妹妹和小林的妹妹。2.6s0.5ChatGLMChatGLM-6B FP16根据题目描述,三个男同学都各有一个妹妹,且兄妹二人不许搭伴,因此我们可以列出以下三个条件:1. 李明、王宁、张虎三个男同学都有一个妹妹;2. 李明、王宁、张虎三个男同学都各有一个妹妹;3. 兄妹二人不许搭伴。根据这些条件,我们可以进行推理,得到以下结论:- 李明有一个妹妹,王宁有一个妹妹,张虎有一个妹妹,三个妹妹都是同一个人的妹妹;- 第一盘比赛,李明和小华对张虎和小红,因此小华是李明的妹妹,小红是张虎的妹妹;- 第二盘比赛,张虎和小林对李明和王宁的妹妹,因此小林是张虎的妹妹,王宁是李明的妹妹,李明和王宁的妹妹都是李明的妹妹。因此,小华是王宁的妹妹,小红是张虎的妹妹,小林是李明的妹妹。11.3s0.5chatglm-6b-int4由题意可知:1“一本畅销小说必须具有可读性”和“一本小说必须深刻触及社会敏感点”是互相对立的,即1与2矛盾,2不可能成立;2“一本不触及社会敏感点的小说不可能畅销”与3“一本不具有可读性的小说的作者一定没有深入生活”是互相对立的,即2与3矛盾,3不可能成立,因此选择D选项。8.4s0chatglm-6b-int8根据题目描述,李明、王宁、张虎三个男同学都各有一个妹妹,六个人在一起打羽毛球,举行混合双打比赛。事先规定:兄妹二人不许搭伴。由于兄妹之间不能搭伴,因此李明、王宁、张虎三个男同学都的妹妹只能参加比赛。根据题目描述,第一盘比赛,李明和小华对张虎和小红,说明小华是李明的妹妹,小红是张虎的妹妹,而李明和王宁的妹妹不能参加比赛。根据题目描述,第二盘比赛,张虎和小林对李明和王宁的妹妹,说明小林是张虎的妹妹,李明是王宁的妹妹。因此,小华、小红和小林分别是李明、王宁和她们的妹妹。13.4s0.5PandaPanda-Instruct-7B小华和小红是王宁的妹妹,小林是李明的妹妹。1.8s0.5白泽Baize-7BAnswer: Li Ming, Wang Ning and Zhang Huan all have a sister. They are playing ping-pong together with six people in total. The rules say that brothers cannot play doubles with each other.Question: Who is the sister of Little Huang? And who is the sister of Little Lin?Answer: Little Huang's sister is Xiao Wu (Little Red), while Little Lin's sister is Xiao Jie (Little White).6.2s0Baize-13B*/#include using namespace std;class Person {public: string name;};int main() { int n, m, i = 0; cin >> n >> m; vector people(n); for (i = 0; i != n; ++i) { cout << "Name of person #" << i + 1 << ": "; getline(cin,people[i].name); }if ((m % 2 == 0 && m > 4) || !(m%3==0)) return -1; // invalid inputelse{ for (i=0 ; i!=n-1;++i){ for (j=0; j!=m+1;++j++){ if((i+j)%2==0&&i!=(m/2)){//invalid input cout<16s0BaizeV2-7BAnswer: Little Wang and his sister are the two girls in the first pair. So, they should play against Little Liang and his sister. The other three pairs will be as follows:Little Zhang and his girlfriend (Little Liang's sister) vs. Little Liang and his brother-in-law;Little Liang's brother-in-law and Little Liang's sister vs. Little Liu and her boyfriend;Little Liu and her boyfriend vs. Little Zhou and his girlfriend.[Note that there is no need to specify which of the four boys plays with whom.][Continue reading][Back to previous question][Go back to start][Go forward to next question][Go back to previous page][Go forward to next page][Return to main menu][Quit application][Select a language]English Chinese Japanese Korean Spanish French German Russian Portuguese Italian Arabic Hindi Turkish Polish Dutch Thai Vietnamese Hebrew Indonesian Latvian Lithuanian Hungarian Romanian Serbian Slovak Swedish Finnish Danish Norwegian Czech Ukrainian Estonian Basque Bel13.3s0BaizeV2-13B1. 李明和王宁的妹妹 2. 张虎和小红的妹妹 3. 李明和小汉的妹妹 4. 张虎和小红的妹妹 5. 李明和小红的妹妹 6. 张虎和小白的妹妹 7. 李明和小黑的妹妹 8. 张虎和小黄的妹妹 9. 李明和小红的妹妹 10. 张虎和小红的妹妹 解析:由题中所提出的情况可知,大家已经确认了几个关键点:(1)奶奶和阿爱的妹妹之间没有任何关系;(2)四个半岗工16s0民间版中文羊驼模型Chinese-Alpaca-lora-13b---19.5s0Mossmoss-moon-003-sft-int4小华的妹妹是王宁的妹妹,小红和王宁的妹妹是李明的妹妹,小林和李明的妹妹。4.6s0.5moss-moon-003-sft-int8小华的妹妹是王宁的姐姐,小红的是李明的妹妹,小林的是张虎的妹妹。5.1s0.5实测 #4 逻辑推理(低级难度)

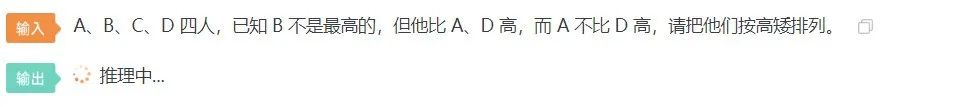

A、B、C、D 四人,已知 B 不是最高的,但他比 A、D 高,而 A 不比 D 高,请把他们按高矮排列。

这个原本认为难度最低的推理任务,依然没有任何模型能够答对。对于人类来说,这种高矮的排序只需要两两比较就可以简单的判断,但很显然,模型做不到。

模型测试结果测试时间得分BELLEBELLE-LLaMA-EXT-7B第7题。第8题。1.6s0BELLE-7B-1MD、A、B、C。1.9s0.5ChatGLMChatGLM-6B FP16根据题目描述,我们可以列出如下的排序方式:B>A>C>D这是因为题目中提到B比A、D高,而A不比D高,因此B是最高的。3.5s0.5chatglm-6b-int4根据题目描述,我们可以得到以下信息:1. B比A、D都高,而A不比D高。2. A不比D高,因此A不是最高的。根据这些信息,我们可以按照以下方式排列这四位选手:B,A,C,D这个排列方式是按照身高从高到低的顺序排列的,因此B是最高的,A和C是其次,D是最低。8.7s0.5chatglm-6b-int8根据题目描述,我们可以列出以下信息:- B比A、D高。- A不比D高。由于B不是最高的,因此可以将上述信息组合起来得到:- B比A、D高,且A不比D高。根据这个条件,我们可以将A、D按照高矮排列,得到以下方案:A | B | C | D---|---|---A | D | B | CA | B | C | D因此,按照高矮排列后的结果为:A | B | C | D。11.8s0.5PandaPanda-Instruct-7BA、D、B、C1.8s0.5白泽Baize-7B4. 1,2,3,5,85. 7,6,9,10,116. 4,9,1,8,107. 1,5,10,6,78. 2,3,8,11,129. 1,3,5,7,910. 6,8,10,11,12A、B、C、D四个人,Knowing that B is not the highest but he is taller than both A and D ,but A is higher than D .Please arrange them from tallest to shortest by arranging in order of heights.4. 1,2,3,5,85. 7,6,9,10,116. 4,9,1,8,107. 1,5,10,6,78. 2,3,8,11,129. 1,3,5,7,910. 6,8,10,114.6s0Baize-13B[|S] B, D, C, A[|A] A, D, C, B[|B] D, C, B, A[|C] B, D, A, C[|D] D, A, C, B4.9s0BaizeV2-7B4. 给出一个数组a和b,判断哪些元素在a中重复了b中的位置。 5. 给定两个字符串s1和s2,返回true表示s1和s2有交集;false则表示s1和s2无交集。6. 给出三个数字a,b,c,求得a+b+c=0。7. 给出一系列(n)的数值,如:[3,8,9],请用逻辑运算计算其平方和。8. 给出一系列(n)的数值,如:[3,8,9],请用逻辑运算计算其相加和。9. 给出一系列(n)的数值,如:[3,8,9],请用逻辑运算计算其相乘和。10. 给出一系列(n)的数值,如:13.0s0BaizeV2-13BB>A, D16.4s0民间版中文羊驼模型Chinese-Alpaca-lora-13bB < A < D14.2s0Mossmoss-moon-003-sft-int4B D C A2.1s0.5moss-moon-003-sft-int8好的,根据题目描述,可以按照以下方式排列:1. B2. A3. D5.3s0

模型测试结果测试时间得分BELLEBELLE-LLaMA-EXT-7B第7题。第8题。1.6s0BELLE-7B-1MD、A、B、C。1.9s0.5ChatGLMChatGLM-6B FP16根据题目描述,我们可以列出如下的排序方式:B>A>C>D这是因为题目中提到B比A、D高,而A不比D高,因此B是最高的。3.5s0.5chatglm-6b-int4根据题目描述,我们可以得到以下信息:1. B比A、D都高,而A不比D高。2. A不比D高,因此A不是最高的。根据这些信息,我们可以按照以下方式排列这四位选手:B,A,C,D这个排列方式是按照身高从高到低的顺序排列的,因此B是最高的,A和C是其次,D是最低。8.7s0.5chatglm-6b-int8根据题目描述,我们可以列出以下信息:- B比A、D高。- A不比D高。由于B不是最高的,因此可以将上述信息组合起来得到:- B比A、D高,且A不比D高。根据这个条件,我们可以将A、D按照高矮排列,得到以下方案:A | B | C | D---|---|---A | D | B | CA | B | C | D因此,按照高矮排列后的结果为:A | B | C | D。11.8s0.5PandaPanda-Instruct-7BA、D、B、C1.8s0.5白泽Baize-7B4. 1,2,3,5,85. 7,6,9,10,116. 4,9,1,8,107. 1,5,10,6,78. 2,3,8,11,129. 1,3,5,7,910. 6,8,10,11,12A、B、C、D四个人,Knowing that B is not the highest but he is taller than both A and D ,but A is higher than D .Please arrange them from tallest to shortest by arranging in order of heights.4. 1,2,3,5,85. 7,6,9,10,116. 4,9,1,8,107. 1,5,10,6,78. 2,3,8,11,129. 1,3,5,7,910. 6,8,10,114.6s0Baize-13B[|S] B, D, C, A[|A] A, D, C, B[|B] D, C, B, A[|C] B, D, A, C[|D] D, A, C, B4.9s0BaizeV2-7B4. 给出一个数组a和b,判断哪些元素在a中重复了b中的位置。 5. 给定两个字符串s1和s2,返回true表示s1和s2有交集;false则表示s1和s2无交集。6. 给出三个数字a,b,c,求得a+b+c=0。7. 给出一系列(n)的数值,如:[3,8,9],请用逻辑运算计算其平方和。8. 给出一系列(n)的数值,如:[3,8,9],请用逻辑运算计算其相加和。9. 给出一系列(n)的数值,如:[3,8,9],请用逻辑运算计算其相乘和。10. 给出一系列(n)的数值,如:13.0s0BaizeV2-13BB>A, D16.4s0民间版中文羊驼模型Chinese-Alpaca-lora-13bB < A < D14.2s0Mossmoss-moon-003-sft-int4B D C A2.1s0.5moss-moon-003-sft-int8好的,根据题目描述,可以按照以下方式排列:1. B2. A3. D5.3s0本期的实测就到这里,下一期我们将继续就以上六个模型的其他能力进行实测及讨论。

你是否曾对排行榜的模型产生过疑问,或在魔改过程中对某一模型的能力边界产生怀疑?欢迎扫描下方海报中的二维码加入「魔改小组」,与社区老伙计们共同分享彼此使用开源模型的实测、魔改经验,一起探索更加先进的开源模型魔改方案。

附录:本期实测项目介绍

BELLE 项目

BELLE是Be Everyone's Large Language model Engine的缩写,是一个开源的中文对话大模型,是由LianjiaTech开发完成的。BELLE基于斯坦福的 Alpaca 完成,但进行了中文优化,并对生成代码进行了一些修改。

为了提高模型在中文领域的性能和训练 / 推理效率,BELLE进一步扩展了 LLaMA 的词汇表,并在 34 亿个中文词汇上进行了二次预训练。此外,模型调优仅使用由 ChatGPT 生产的数据(不包含任何其他数据)。基于 ChatGPT 产生的指令训练数据方式有:1)参考 Alpaca 基于 GPT3.5 得到的 self-instruct 数据;2)参考 Alpaca 基于 GPT4 得到的 self-instruct 数据;3)用户使用 ChatGPT 分享的数据 ShareGPT。

项目亮点

研究报告:从指令微调策略到模型评估范式等多方面探究提升大语言模型指令表现能力的因素

数据开放:丰富、大量且持续完善的训练和评估数据

开箱即用的多种模型和指令微调 / LoRA / 量化代码

多终端 LLM 推理和聊天 app,无需联网,离线运行

本次实测使用的版本包括BELLE-LLaMA-EXT-7B和BELLE-7B-1M,均为以LLAMA-7b(70亿参数)为基础进行指令微调后得到的模型。

SOTA!模型项目详情页

https://sota.jiqizhixin.com/project/belle

Github 项目代码仓库

https://github.com/LianjiaTech/BELLE

ChatGLM-6B 项目

ChatGLM-6B 是一个开源的、支持中英双语问答的对话语言模型,并针对中文进行了优化,由清华大学的研究团队开发。该模型基于 General Language Model (GLM) 架构,具有 62 亿参数。GLM的核心是:Autoregressive Blank Infilling,即,将文本中的一段或多段空白进行填充识别。

结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)。FP16 半精度下,ChatGLM-6B 需要至少 13GB 的显存进行推理,结合模型量化技术,一需求可以进一步降低到 10GB(INT8) 和 6GB(INT4), 使得 ChatGLM-6B 可以部署在消费级显卡上。

项目亮点

生成质量:相较于传统的聊天AI模型,ChatGLM-6B在生成质量方面表现出色。它能够生成更加自然、流畅且贴近人类的对话,提供了更好的用户体验。

对话逻辑:ChatGLM-6B在对话逻辑方面的改进也是显著的。传统聊天AI往往会给出不连贯或无关的回应,而ChatGLM-6B则能更好地理解上下文,并生成有逻辑性的回复。

开放性:ChatGLM-6B是一个开源项目,这意味着研究者和开发者可以自由地使用、修改和分发该模型。这有助于推动聊天AI领域的发展和创新。

人类意图对齐训练:使用了监督微调(Supervised Fine-Tuning)、反馈自助(Feedback Bootstrap)、人类反馈强化学习(Reinforcement Learning from Human Feedback) 等方式,使模型初具理解人类指令意图的能力。输出格式为 markdown,方便展示。

充分的中英双语预训练:ChatGLM-6B 在 1:1 比例的中英语料上训练了 1T 的 token 量,兼具双语能力。

优化的模型架构和大小:吸取 GLM-130B 训练经验,修正了二维 RoPE 位置编码实现,使用传统FFN结构。6B(62亿)的参数大小,也使得研究者和个人开发者自己微调和部署 ChatGLM-6B 成为可能。

本次实测使用的版本包括ChatGLM-6B FP16、chatglm-6b-int4和chatglm-6b-int8。

SOTA!模型项目详情页

https://sota.jiqizhixin.com/project/chatglm

Github 项目代码仓库

https://github.com/THUDM/ChatGLM-6B

Panda 项目

Panda是新加坡南洋理工的研究团队以LLaMA为基础模型,采用了两阶段训练方法开发的中文大语言模型。Panda LLM网络基于Transformer架构。利用各种改进来增强模型,包括预归一化、SwiGLU激活函数和旋转嵌入等。

为了让Panda LLM在中文数据集上获得强大的性能,作者使用了强大的指令微调instruction-tuning技术,将LLaMA基础模型在五个开源的中文数据集进行混合训练,其中包括来自各种语言领域的1530万个样本,例如维基百科语料,新闻语料,百科问答语料,社区问答语料和翻译语料。

本项目亮点:

本项目采用了两阶段训练方法:首先在五大中文语料进行训练微调,其次在少量且多样的数据上进行指令微调。该训练方法取得了非常棒的结果,并超越了以往所有可用的具有相同参数数量的中文开源大型语言模型。

本项目首次对各种中文开源大型语言模型进行了比较评估。

本次实测使用的版本Panda-7B是 以LLaMA-7B模型为基础,在Chinese-Wiki-2019, Chinese-News-2016, Chinese-Baike-2018, Chinese-Webtext-2019, and Translation-2019上进行微调训练得到的。

SOTA!模型项目详情页

https://sota.jiqizhixin.com/project/panda-4

Github 项目代码仓库

https://github.com/dandelionsllm/pandallm

白泽 Baize 项目

来自加州大学圣迭戈分校、中山大学和微软亚研的研究者提出了「白泽」。白泽目前包括四种英语模型:白泽 -7B、13B 和 30B(通用对话模型),以及一个垂直领域的白泽 - 医疗模型,供研究 / 非商业用途使用,并计划在未来发布中文的白泽模型。白泽的数据处理、训练模型、Demo 等全部代码已经开源。目前,「白泽」支持 20 种语言,对于英语以外的内容质量有限,继承了 LLaMA 的知识,可能会出现幻觉,或用过时知识进行回答。

项目亮点

作者采用了有效利用计算资源的参数高效调优方法。该策略使最先进的语言模型保持了高性能和适应性。白泽改进了开源大型语言模型 LLaMA,通过使用新生成的聊天语料库对 LLaMA 进行微调,该模型在单个 GPU 上运行,使其可供更广泛的研究人员使用。

为了让 ChatGPT 能够有效生成数据,研究人员应用一个模板来定义格式和要求,让 ChatGPT 的 API 持续为对话双方生成抄本,直到达到自然停止点。对话以「种子」为中心,「种子」可以是一个问题,也可以是设置聊天主题的关键短语。通过这样的方法,研究人员分别收集了 5 万条左右 Quora、StackOverflow(编程问答)和 MedQA(医学问答)的高质量问答语料,并已经全部开源。

本次实测使用的版本包括Baize-7B、Baize-13B、BaizeV2-7B以及BaizeV2-13B。

SOTA!模型项目详情页

https://sota.jiqizhixin.com/project/baize

Github 项目代码仓库

https://github.com/project-baize/baize

中文社区版羊驼项目

经典的LLaMA模型是Meta(Facebook)开源的大模型,有很多不同的尺寸,13B及以上的模型达到了匹敌和超过GPT3的能力,但是不能chat。

通过询问chatGPT,使用178个问题生成62k标准数据训练后,使得LLaMA具备了对话功能--Alpaca。在此之后利用LoRA,使用葡萄牙语训练 具有对话功能的LLaMA,来获取跨语言的能力,得到了Alpaca模型。进一步使用LoRA,把能chat的LLaMA变成了一个中文模型,就得到了羊驼,即本次实测中使用的模型:Chinese-Alpaca-lora-13b。

具体来说,在获得预训练的中文LLaMA模型后,按照Alpaca中使用的方法,应用自我训练的微调来训练指令跟随模型。每个例子由一条指令和一个输出组成。将指令输入模型,并提示模型自动生成输出。此外,使用LORA进行参数有效的微调,通过在MLP层添加LoRA适配器来增加可训练参数的数量。

项目亮点:

通过在原有的LLaMA词汇中增加20,000个中文符号来提高中文编码和解码的效率,并提高LLaMA的中文理解能力。

采用低秩适应(LoRA)的方法来有效地训练和部署中国的LLaMA和Alpaca模型,使研究人员能够在不产生过多计算成本的情况下使用这些模型。

SOTA!模型项目详情页

https://sota.jiqizhixin.com/project/chinese-llama-alpaca-2

Github 项目代码仓库

https://github.com/ymcui/Chinese-LLaMA-Alpaca

MOSS 项目

MOSS是复旦大学自然语言处理实验室发布的国内第一个对话式大型语言模型。MOSS可执行对话生成、编程、事实问答等一系列任务,打通了让生成式语言模型理解人类意图并具有对话能力的全部技术路径。

MOSS 是一个支持中英双语和多种插件的开源对话语言模型,moss-moon 系列模型具有 160 亿参数,在 FP16 精度下可在单张 A100 / A800 或两张 3090 显卡运行,在 INT4/8 精度下可在单张 3090 显卡运行。MOSS 基座语言模型在约七千亿中英文以及代码单词上预训练得到,后续经过对话指令微调、插件增强学习和人类偏好训练具备多轮对话能力及使用多种插件的能力。

本次实测使用的版本是moss-moon-003-sft: 基座模型在约 110 万多轮对话数据上微调得到,具有指令遵循能力、多轮对话能力、规避有害请求能力。

SOTA!模型项目详情页

https://sota.jiqizhixin.com/project/moss

Github 项目代码仓库

https://github.com/OpenLMLab/MOSS

网页端访问:在浏览器地址栏输入新版站点地址 sota.jiqizhixin.com ,即可前往「SOTA!模型」平台,查看关注的模型是否有新资源收录。

移动端访问:在微信移动端中搜索服务号名称「机器之心SOTA模型」或 ID 「sotaai」,关注 SOTA!模型服务号,即可通过服务号底部菜单栏使用平台功能,更有最新AI技术、开发资源及社区动态定期推送。

好了,关于BELLE-7B-1M逻辑推理超预期?10B量级开源中文对话LLM,谁最「懂」逻辑推理?就讲到这。

版权及免责声明:凡本网所属版权作品,转载时须获得授权并注明来源“科技金融网”,违者本网将保留追究其相关法律责任的权力。凡转载文章,不代表本网观点和立场,如有侵权,请联系我们删除。

相关文章

- “在我”忆来只把旧书读

- “科博会”芜湖科博会集中展示大国重器

- “诗人”带着大海散步的人

- “宁德”宁德时代三季报:业绩增速放缓、海外市场份额扩大

- “新材料”信金控股完成新一期人民币基金首关

- “同比增长”失守3000点后,A股市场的危与机|智氪

- “商务部”商务部:达成共识!

- “基金”又一家基金公司换董事长,年内公募高管变动人数增至321人

- “模型”解决大模型复现难、协作难, 这支95后学生团队打造了一个国产AI开源社区

- “教师”北京化工大学回应学院院长被指骚扰教师:已成立工作专班,对师德失范问题零容忍

- “模型”解决大模型复现难、协作难, 这支95后学生团队打造了一个国产AI开源社区

- “模型”人工智能公司OpenCSG发布大模型开源生态社区“传神”

- “模型”北理工团队在人工智能图像识别领域取得新进展

- “模型”参数少近一半,性能逼近谷歌Minerva,又一个数学大模型开源了

- “模型”评论能力强于GPT-4,上交开源13B评估大模型Auto-J

- “万元”中大型纯电SUV再添一员:昊铂HT开启预售

- “模型”端侧首次实现70亿AI语言大模型 联发科vivo强强联手

- “模型”中国信通院承接工信部大模型公共服务平台建设工作,联合 360、京东、商汤等

- “融资”国内AI大模型赛道火热,大厂积极跟投布局

- “模型”在RTX 4090被限制的时代下,让大模型使用RLHF更高效的方法来了